前回までに、ESXiからAHVへの移行が簡単にかつ、ダウンタイムをかなり短く行うことが出来ることが分かりました。

では、今回はHyper-VからAHVへの仮想マシン移行についてご紹介します。

今回は、Nutanix Move 3.4を利用して作業を行います。

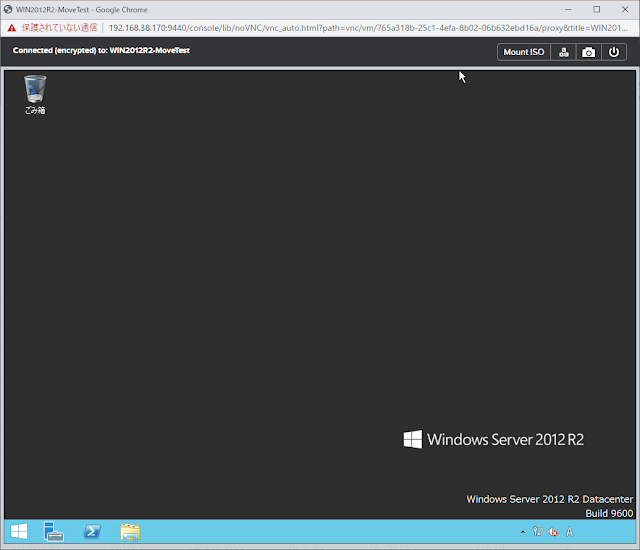

移行元環境は、Windows Server 2012R2で、第2世代の仮想マシン対応で構成された環境にWindows Server 2012 R2をインストールした仮想マシンを移行します。

まずは、Nutanix MoveのSourceにHyper-Vを登録します。

すると、add the environment と表示されしばらく待ちが発生します。

このタイミングでHyper-Vホスト側にWinRM機能を利用して、MoveのAgentがインストールされます。インストール場所は、上記のSourceを登録する際のユーザープロファイルの配下にできあがります。この環境は、Administratorで登録をしていますので、「C:\Users\Administrator\Nutanix\Move\3.4」になります。

併せて、「move-service.exe」 が、「Nutanix Move Agent」という名前でサービスに登録されます。

なお、Move3.2までは、このAgentが日本語版のWindowsですとうまくインストールが出来ませんでした。これは、インストール時に利用しているPowerShellのコードが日本語に対応していないことに由来していましたが、Move3.3.1以降では、問題なく日本語環境でもインストールが可能です。

もし、Agentのインストールに失敗し、Sourceの登録に失敗した場合、Agentを手動でHyper-Vホストにインストール後、再度Source登録することで成功する可能性が高いです。

Agentバイナリは、Moveアプライアンスにhttp経由でアクセスします。

http://<nutanix-move-ip>/downloads/agents/move-agent-installer.exe

ダウンロードしたバイナリを、Hyper-Vホストにインストールします。

なお、インストール時には以下のパラメーターを入力します。

move-agent-installer.exe -o install <nutanix-move-ip> -u Administrator

最後のAdministratorは、サービスを起動するユーザーに紐付きますので、Administratorと書きましたが、実際には管理者権限を保有したユーザーとなります。

なお、AgentをインストールするとWindows Firewallにて、8087番のポートが開放されるルールが追加されます。このポート番号は、MoveとAgentがやりとりするために利用され、ポート番号を変更することはできません。

では、続いて、マイグレーションプランを作成します。

続いてソース環境とターゲット環境のNutanixを登録します。

続いて、移行したい仮想マシンの「+」マークをクリックし、移動対象のVMに登録します。ここで!マークが表示されます。

この内容は、セキュアブートに関する注意事項です。

第2世代の仮想マシンでは、カットオーバープロセス中及びカットオーバーが完了するまでは、仮想マシンのセキュアブート機能は無効になります。カットオーバープロセスが終了すると、セキュアブート機能が再び有効化されます。

▼Hyper-Vで第2世代仮想マシンを作成するとデフォルトでセキュアブートが有効になる

セキュアブートは自動的に無効にされ、移行終了後にHyper-V側のソース仮想マシンは元の設定に戻りますが、セキュアブートが必要でない場合はあらかじめチェックを外しておいてもよいかと思います。なお、セキュアブートの無効化は該当の仮想マシンがパワーオフ状態の時のみ設定変更が可能です。

続いてネットワークのマッピングを行います。

ここで出てくるにSource Networkは、Hyper-Vホストのアダプタになります。

割り当てるネットワークは、仮想マシンが通信したいネットワークになります。

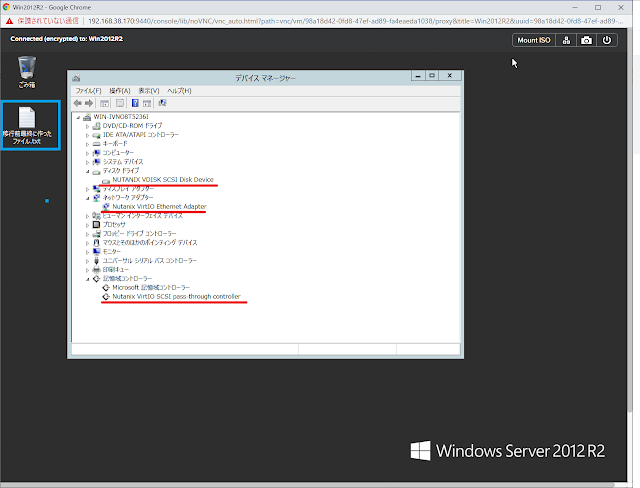

この画面では、vSphere同様、ゲストOSへVirt IO Driverをインストールするためのcredential情報の入力を行います。vSphereの場合同様複数の仮想マシンを一括して移行する場合、仮想マシン個別のcredential情報を入力することも可能です。

また、Move 3.4からタイムゾーンの設定項目も追加されました。

ここでは、「Asia/Tokyo」を選択します。

Hyper-Vの仮想NICに付与されたMac Addressをを引き継ぐ場合は、「Retain MAC Addresses form the Source VMs.」にチェックを入れます。

最後にサマリーを確認し、「Save and Start」をクリックします。

これで、Hyper-Vの仮想マシンにVirtI/O Driverなど必要なモジュールが、「C:\Nutanix」に配置されます。

Hyper-Vマネージャーで確認すると、vSphereと同様にチェックポイント(スナップショット)が順次取得されているのが分かります。

では次回に実際に、カットオーバーを行いAHVへの移行を行ってみましょう。