前回までに、Nutanix側の設定をメインに構成しました。

今回は、続きとしてWindows側の設定を行っていきます。

7.ホスト名の設定

起動した2台の仮想マシンのホスト名を設定します。ここでは、以下のとおりホスト名を設定します。

以下のようにそれぞれホスト名を設定し、Windows Serverを再起動します。

8.NICの設定

まずはそれぞれのNIC名称を変更します。ここでは、Nutanix上で設定しているVLAN名のと同じ名称に変更します。

続いて、NICの設定を行います。以下のようにIPアドレスの設定を行います。

まず1号機「ORACLE19C-LK01」の設定を行います。

サービス系(SERVICE)のNICの設定

▼NICの設定

コミュニケーションパス(HB)のNIC設定

▼NIC設定

SMBとIPv6は利用しないため、チェックを外す

▼IPアドレスの設定

▼メトリック値を100に設定

ストレージパス(iSCSI)NICの設定

▼IPアドレスの設定

SMBやIPv6は利用しないため、チェックを外します。

▼IPアドレスの設定

▼メトリック値を200に設定

▼DNSの登録のチェックを外す

同じ設定(IPアドレス以外)を「ORACLE19C-LK02」のホストにも行っていきます。

9.メディア検出の無効化

TCP/IPのメディア検出設定を無効化します。

レジストリエディタ(regiedit.exe)を起動し、

「HKEY_LOCAL_MACHINE\System\CurrentControlSet\Services\Tcpip\Parameters」を開きます。

パラメーター「DisableDHCPMediaSense」をDWORDで設定し値を「1」にします。

10.Distributed Link Tracking Clientの自動起動停止

Windowsのサービスから「Distributed Link Tracking Client」を開き、スタートアップの種類を「手動」に変更します。

11.iSCSI経由でNutanix Volumesをマウント

コントロールパネルからiSCSIイニシエーターを開きます。

サービスの自動起動の確認が行われますので、「はい」をクリックします。

Nutanixで設定したDATA SERVICE IPを入力し、「クイック接続」をクリックします。

Nutanix Volumesで設定した2つのLUNが見えます。それぞれのLUNを選択し「接続」ボタンをクリックします。

同様の設定を、「ORACLE19C-LK02」側も設定を行います。

12.ストレージの設定

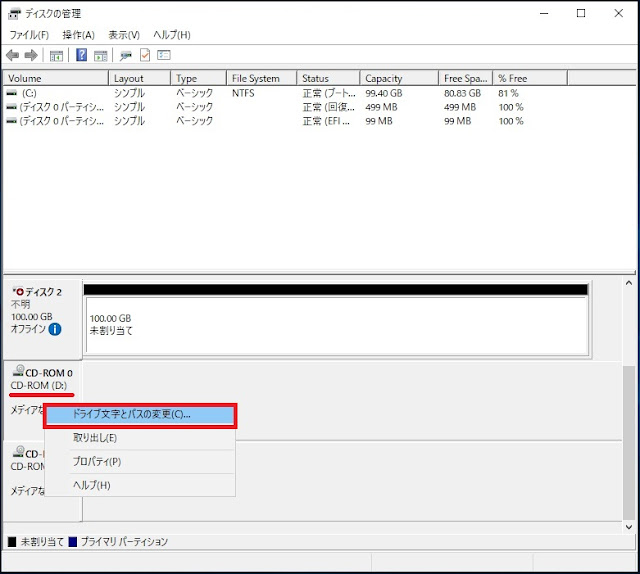

スタートボタンを右クリックし、「ディスクの管理」を開きます。

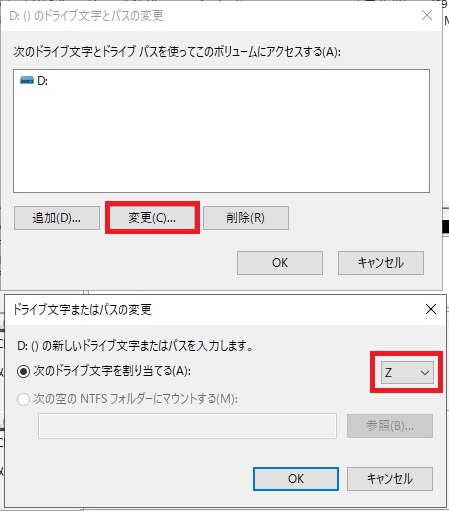

まずは、CDROMドライブのドライブレターを変更します。

ドライブレターをZに変えます。

同様にもう1台のCDROMドライブを変更し、YドライブとZドライブに変更します。

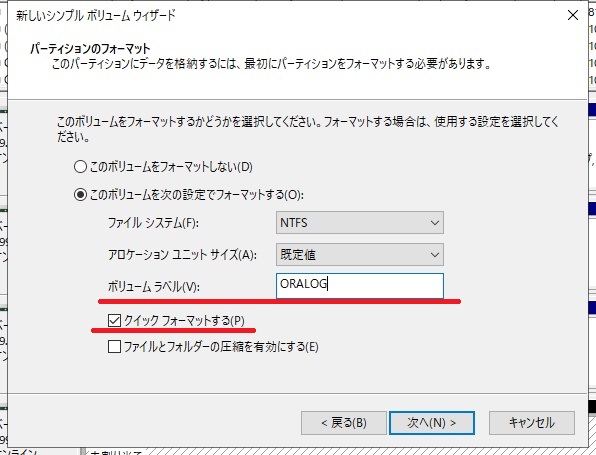

続いて、各ドライブをフォーマットしていきます。

まずディスク1は、仮想マシンのローカルディスクとして構成しています。初期化を行い、GPTパーティションとして設定します。

続いてシンプルボリュームでDドライブとして構成します。

ドライブレターをDドライブとして設定します。

ボリュームラベルは、「ORAHOME」と設定し、クイックフォーマットを行います。

同様にディスク2もGPTで初期化後、シンプルボリュームで作成します。

▼Oドライブ(Oracleデーターファイル配置場所)

同様にディスク3もGPTで初期化後、シンプルボリュームで作成します。

▼Pドライブ(アーカイブログ配置エリア)

次に、2台目の「ORACLE19C-LK02」のディスクの管理を開きます。

最初にCDROMドライブを1号機の「ORACLE19C-LK01」と同様に「Z」ドライブと「Y」ドライブに、ドライブレターを割り付けなおします。

続いて同様にディスク1をDドライブとして設定しラベルに「ORAHOME」として設定します。

続いて、Nutanix Volumesから見ている共有ディスクボリューム(ディスク2,ディスク3)を、オンラインにします。

ドライブレターは、1号機の「ORACLE19C-LK01」と同じレターにする必要があるため、CDROMドライブのドライブレター変更と同じ要領で、それぞれ「O」と「P」ドライブに変更します。

▼変更前

▼変更後

ここまでで基本設定は終わりました。次回は、LifeKeeperのインストールを行います。